Kiedy ponad rok temu, razem z kilkoma innymi programistami z zespołu, wystartowaliśmy w HackJam, postanowiliśmy zmierzyć się z tematem sztucznej inteligencji w game devie. Szukaliśmy pomysłu, który pozwoliłby wykorzystać AI w mniej oczywisty sposób niż tylko do generowania grafik czy ścieżek audio (choć z tych możliwości również skorzystaliśmy).

Ostatecznie zdecydowaliśmy się stworzyć prototyp gry z zagadkami środowiskowymi, w której centralną rolę odgrywał narrator napędzany przez AI. W czasie rzeczywistym komentował on działania gracza, dopasowując ton i styl wypowiedzi do przebiegu rozgrywki. Dzięki temu każda sesja była unikalnym doświadczeniem, a opowieść różniła się w zależności od podejmowanych decyzji.

Projekt powstawał w typowych dla game jamu warunkach – szybko, chaotycznie i mocno eksperymentalnie – ale pokazał nam coś ważnego: AI nie musi zastępować człowieka, by robić wrażenie. Największa wartość pojawia się wtedy, gdy technologia staje się wsparciem dla kreatywności twórców.

Od tamtej pory branża zrobiła ogromny krok naprzód, a zastosowania AI w gamedevie rozwinęły się w kierunkach, o których wówczas nawet nie myśleliśmy. W tym artykule chciałbym przedstawić kilka nietypowych zastosowań AI w game dev idących krok dalej niż typowe generowanie treści.

Zastosowania AI w tworzeniu gier

Motion Matching – rwolucja w animacji postaci

Jednym z najbardziej imponujących przełomów jest system motion matching, który najlepiej widać w The Last of Us Part II. Zamiast tradycyjnych, sztywnych przejść między animacjami, AI analizuje tysiące klatek ruchu i w czasie rzeczywistym dobiera najbardziej naturalne sekwencje. Postacie poruszają się jak prawdziwi ludzie, płynnie reagując na każdą zmianę terenu czy nagłą zmianę kierunku.

Ubisoft poszedł jeszcze dalej z systemem Learned Motion Matching, który nie tylko dobiera animacje, ale też generuje nowe na podstawie istniejących danych. To już nie jest odtwarzanie gotowych sekwencji – to AI faktycznie „rozumiejące” biomechanikę ruchu i tworzące coś nowego w locie. Efekt? Animacje, które wyglądają naturalnie w każdej sytuacji, bez sztucznych „sklejeń” między ruchami.

Ubisoft i AI do analizy kodu

Równie fascynujące – choć mniej widowiskowe – jest podejście Ubisoftu do wykorzystania AI w samym procesie tworzenia gier. Ich system automatycznie analizuje każdy commit kodu i flaguje potencjalne problemy już na etapie developmentu. To jak mieć doświadczonego seniora, który ciągle zagląda przez ramię i ostrzega przed potencjalnymi bugami, problemami z wydajnością czy błędami logicznymi.

W praktyce oznacza to mniej crunchów, szybsze cykle developmentu i – co najważniejsze – mniej frustrujących bugów w finalnej wersji gry. To AI w służbie deweloperów, nie graczy, ale efekt odczuwają wszyscy.

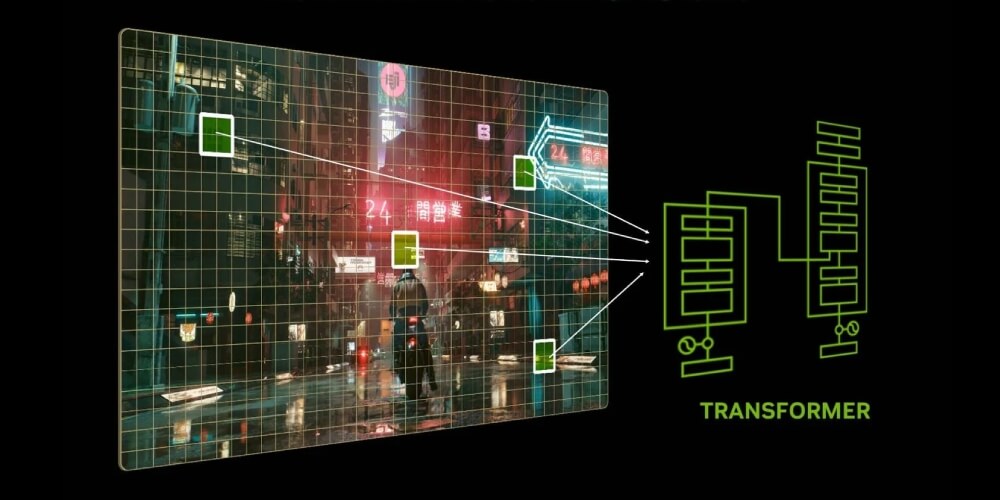

DLSS 4.0 – rewolucja w renderowaniu

DLSS w wersji 4 to już nie tylko upscaling obrazu – to całkowicie nowy model AI, który generuje dodatkowe klatki i znacząco poprawia wydajność w grach. Technologia pozwala graczom na osiągnięcie wysokich klatek animacji nawet w najbardziej wymagających tytułach, przy jednoczesnym zachowaniu jakości obrazu. Dla właścicieli kart ze średniej półki to często jedyna możliwość komfortowego grania w najnowsze tytuły w wysokiej rozdzielczości.

Problem w tym, że DLSS stał się zbyt wygodną alternatywą dla właściwej optymalizacji. Zamiast poprawiać kod i optymalizować gry, deweloperzy często po prostu obniżają rozdzielczość renderowania i pozwalają DLSS zrobić resztę. To trochę jak używanie filtrów zamiast dbania o dobrą fotografię – efekt może być podobny, ale podstawowe problemy pozostają nierozwiązane. DLSS świetnie sprawdza się jako dodatek do dobrze zoptymalizowanej gry, ale nie powinien być pretekstem do leniwego podejścia do gamedevu.

NVIDIA Neural Texture Compression – ratunek dla kart z małą pamięcią

Jednym z największych problemów popularnych kart graficznych ze średniej półki jest ograniczona ilość pamięci VRAM. Gdy gry wymagają coraz więcej pamięci do przechowywania tekstur, karty z 8GB czy nawet 12GB VRAM szybko osiągają swoje limity. NVIDIA wprowadza technologię Neural Texture Compression, która może być odpowiedzią na ten problem, zmniejszając zużycie pamięci nawet o 90% przy zachowaniu jakości tekstur.

AI uczy się kompresować tekstury w sposób, który tradycyjne algorytmy uważałyby za niemożliwy. W praktyce oznacza to znacznie bardziej szczegółowe światy gier na kartach, które do tej pory borykały się z brakiem VRAM. Technologia działa już na starszych kartach graficznych – od serii RTX 4000 wzwyż – co pokazuje, że AI w gamedevie to nie tylko zabawka dla właścicieli najdroższego sprzętu.

Text-to-Speech i etyczne dylematy

Współczesne systemy text-to-speech znacznie się poprawiły, choć wciąż można je odróżnić od prawdziwych aktorów przy uważnym słuchaniu. Cyberpunk 2077 pokazał bardzo wyważone i etyczne podejście do tej technologii, używając AI do wygenerowania brakujących kwestii po śmierci jednego z aktorów głosowych – z pełną zgodą i współpracą z rodziną artysty.

Problem może się jednak pojawić w przyszłości, gdy studia zaczną wykorzystywać głosy aktorów bez ich zgody lub odpowiedniego wynagrodzenia. Jednocześnie technologia otwiera drzwi do lokalizacji gier na niespotykaną dotąd skalę – zamiast zatrudniać setki aktorów w każdym kraju, studio może wytrenować AI na kilku głosach i wygenerować naturalne dialogi w dziesiątkach języków. To demokratyzacja dostępu do gier na globalną skalę.

NVIDIA ACE – przyszłość czy Proof of Concept?

NVIDIA ACE pozwala na tworzenie NPC-ów zdolnych do prowadzenia naturalnych rozmów z graczami. Każda rozmowa może być unikalna, każde pytanie otrzymuje kontekstową odpowiedź. NVIDIA pokazało już demos w PUBG, gdzie AI-partners komunikują się z graczami jak prawdziwi ludzie.

Choć technologia robi wrażenie, pozostaje pytanie o jej praktyczność. Czy gracze faktycznie chcą aż tak realistycznych NPC-ów? Czasem prostota i przewidywalność mają swój urok. ACE może być przełomem, ale równie dobrze może okazać się drogą technologiczną ciekawostką.

Następny poziom – co dalej?

Tak jak obecnie powszechne jest generowanie obrazów przez AI, a filmy tworzone przez sztuczną inteligencję wchodzą na kolejny poziom jakości, tak obecnie raczkujące tworzenie modeli 3D przez AI prawdopodobnie pójdzie podobną drogą. Już dziś możemy generować podstawowe modeli 3D z opisów tekstowych, ale to dopiero początek tej rewolucji.

A może czeka nas zupełnie nowy paradygmat renderowania oparty o Gaussian Splats? To jednak temat na zupełnie inną opowieść, która zasługuje na osobny artykuł.

Przyszłość AI w gamedevie

Jensen Huang z NVIDIA przewiduje, że do 2030 roku zobaczymy pierwsze całkowicie generowane przez AI gry. Google eksperymentuje już z AI, które renderuje pseudo-gry generowane jak filmy, ale z zachowaniem ciągłości świata i inputem od gracza. Myślę jednak, że to ślepa uliczka – przyszłość leży raczej w wykorzystaniu AI jako narzędzia w procesie tworzenia gier.

Współczesny gamedev to coraz dłuższy i droższy proces. Niektóre gry AAA są produkowane przez 5-7 lat, kosztując setki milionów dolarów. AI może pomóc skrócić te cykle, automatyzując żmudne zadania i pozwalając deweloperom skupić się na tym, co naprawdę ważne – kreatywności i innowacyjności.

Ważne jednak, żeby pamiętać, że AI ma być współtwórcą, nie konkurentem dla ludzi. Najlepsze rezultaty powstają, gdy technologia wspiera kreatywność deweloperów, a nie ją zastępuje. Ostatecznie to ludzie nadają grom duszę i emocje – AI tylko pomaga im to robić szybciej i efektywniej.