O CZYM PISZEMY?

Wczytywanie...

Onboarding VR w świecie TikToka – przepis na zaangażowanie młodego pokolenia

Krótka koncentracja, ciągłe przeskakiwanie między bodźcami i nowe przyzwyczajenia młodych ludzi to już nasza codzienność – nie tylko na TikToku, ale i w pracy. Czy onboarding nadąża za tym tempem zmian? Zobacz, jak VR wpisuje się w świat błyskawicznego konsumowania treści.

4 grudnia 2025

3 minuty

AI w gamedevie: jak AI zmienia oblicze tworzenia gier

Kiedy ponad rok temu, razem z kilkoma innymi programistami z zespołu, wystartowaliśmy w HackJam, postanowiliśmy zmierzyć się z tematem sztucznej inteligencji w game devie. Szukaliśmy pomysłu, który pozwoliłby wykorzystać AI w mniej oczywisty sposób niż tylko do generowania grafik czy […]

23 października 2025

5 minut

Java + AI w 5 minut: prosty mikroserwis z analizą sentymentu z OpenAI (cz.2)

W tym krótkim tutorialu pokażemy Ci, jak stworzyć mikroserwis w Spring Boot, który analizuje sentyment tekstu z pomocą OpenAI. Bez trenowania modeli, bez przechodzenia na Pythona – tylko czysta Java, szybka konfiguracja i gotowe API. Zobacz, jak dodać inteligencję językową do swojej aplikacji w kilka minut!

31 lipca 2025

4 minuty

Java + AI w 5 minut: czy to ma sens skoro jest Python (cz.1)

Python dominuje w AI, ale Java nie musi oglądać się na konkurencję z zazdrością. W rzeczywistości to właśnie Java bywa najlepszym wyborem tam, gdzie modele sztucznej inteligencji mają trafić do gotowych, stabilnych aplikacji produkcyjnych. Jeśli Twoja firma działa na JVM […]

15 lipca 2025

3 minuty

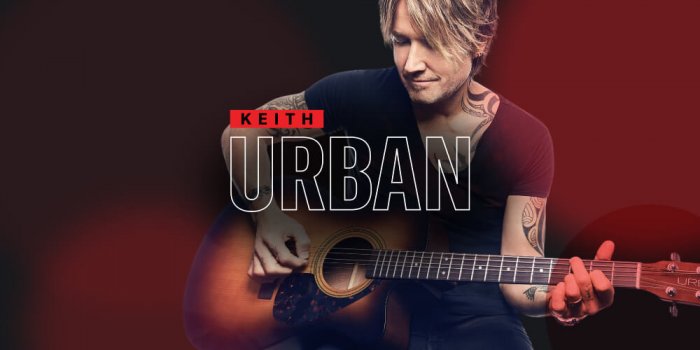

Co wspólnego mają Yamaha, Keith Urban i itSilesia?

Co łączy Yamahę, Keitha Urbana i polski software house? Innowacyjna aplikacja do nauki gry na gitarze, która inspiruje do codziennej praktyki, wykorzystując grywalizację i technologię Unity.

26 marca 2025

2 minuty

Aplikacje targowe – HIT czy KIT?

Zastanawiasz się, czy inwestycja w interaktywne aplikacje na stoisku targowym naprawdę się opłaca? Sprawdź, kiedy takie rozwiązania przynoszą realną wartość biznesową – i jak uniknąć kosztownych rozczarowań.

16 marca 2023

2 minuty

2022 – podsumowanie roku

Ani się obejrzeliśmy, a kolejny rok wspólnych przygód i pracy za nami! Zapraszamy na podsumowanie 2022 w itSilesia!

2 stycznia 2023

3 minuty

Dlaczego używamy AI w VR i AR?

Ważniejsze od pytania „dlaczego?” jest pytanie „do czego będzie wykorzysytwane AI?”. AR i VR to pośrednia i bezpośrednia interakcja sprzętu i oprogramowania z człowiekiem. O różnicach między technologiami AR i VR pisaliśmy już na naszym blogu (tutaj). Ponieważ każdy z nas […]

3 listopada 2021

8 minut

Krótko o tym, co to jest sztuczna inteligencja.

Czym naprawdę jest AI, jak powstała i czy rzeczywiście może dorównać ludzkiemu mózgowi? Odkryj fascynujące kulisy powstawania inteligentnych algorytmów – i sprawdź, czy AI to przyszłość, która już się dzieje.

1 września 2021

4 minuty

Czym różni się AR od VR?

Technologie rozszerzonej (AR – Augmented Reality) i wirtualnej (VR – Virtual Reality) rzeczywistości to coś, o czym chyba słyszał już każdy. Ich popularność, wynikająca prawdopodobnie z widowiskowości przy jednocześnie stosunkowo dużej dostępności, nie maleje. Technologie te wciąż są rozwijane i […]

4 sierpnia 2021

4 minuty

Podsumowanie roku 2020 w itSilesia

Ukończenie prototypu naszego produktu BELL VR Dzięki wsparciu uzyskanemu w ramach konkursu Design dla przedsiębiorców udało nam się zrealizować prototyp narzędzia do prowadzenia szkoleń i prezentacji w VR. Platforma umożliwia zaprezentowanie grupie użytkowników urządzenia, sposobu działania, czynności serwisowych, Znajduje również […]

27 stycznia 2021

3 minuty

Jak debugować kod w Unity

Czasami zdarza się, że coś dzieje się inaczej, niż się tego spodziewamy. W takich sytuacjach często konieczne jest dokładne zbadanie przyczyn i przebiegu działania naszego kodu. Zwykle pierwszym krokiem jest dodanie gdzieś Debug.Log w miejscu, w którym spodziewamy się wystąpienia […]

22 stycznia 2021

3 minuty

Wirtualna rzeczywistość (VR) w biznesie – więcej niż atrakcyjny gadżet

Wirtualna rzeczywistość (VR) od kilku lat szturmem zdobywa targi, stoiska promocyjne, muzea oraz eventy branżowe. Gdy w sali konferencyjnej pojawia się hasło „pokażmy się jako nowoczesna firma”, prawdopodobnie jedna z pierwszych propozycji to „zróbmy coś w VR”. I słusznie […]

2 lipca 2020

2 minuty

My feelings after the first use of Gatsby

How it started Recently, I was asked to create a static site for the client (kind of landing page) in a really short time with the deadline approaching. The first thing I had to do was to choose a technology […]

23 stycznia 2020

4 minuty

How NOT to Write Code in React JS

React, Vue, Angular, Ember, Backbone, Polymer, Aurelia, Meteor, Mithril.js, Preact… There are many super fancy Javascript frameworks nowadays. We can write anything we want, it’s comfortable, easy to understand, although difficult to master. After few lines of code, even […]

26 listopada 2019

8 minut

Neo4j with Spring Boot

In this article, I will show you the advantages and disadvantages of the neo4j graph database, the technology that is being used by big companies like Google, Facebook or PayPal. I will also show you how to create and populate […]

10 czerwca 2019

6 minut

6 Tips That Every MySQL User Should Know

Over the last 3 years, I have been working with MySQL almost every day. Even though non-relational databases like MongoDB are gaining more and more popularity every year, traditional SQL solutions are still widely used for many purposes. In this

15 kwietnia 2019

7 minut

Let’s shake some trees – how to enhance the performance of your application

Nowadays JavaScript applications are getting bigger and bigger. One of the most crucial things while developing is to optimise the page load time by reducing the size of the JavaScript bundle file. JavaScript is an expensive resource when processing and […]

14 stycznia 2019

3 minuty

Wdrożenie systemu ciągłej integracji przy użyciu GitLab i Unity

Po niezliczonych dniach i nocach poświęconych ręcznemu tworzeniu aplikacji, w końcu postanowiliśmy usprawnić część naszego procesu za pomocą automatyzacji. Ale… dlaczego? Naszym głównym celem wdrożenia systemu Continuous Integration było skrócenie czasu poświęcanego na budowanie aplikacji. W poprzednim projekcie pojedyncze […]

21 września 2018

3 minuty

Kubernetes na każdą kieszeń — uruchom klaster, nie rujnując budżetu

Od kilku lat Kubernetes udowadnia, że jest najlepszym oprogramowaniem do orkiestracji kontenerów na rynku. Dziś wszyscy trzej największy dostawcy chmury (Amazon, Google i Azure) oferują zarządzane klastry Kubernetes: odpowiednio EKS, GKE i AKS. Wszystkie te usługi są gotowe do produkcji […]

19 września 2018

5 minut

I’ve got the power – how to control remotely your PC using Grails

In this article I will show you how to control remotely your windows computer via the local network using Linux machine and Grails application. First we will turn on a device with Wake-On-LAN (WOL) method and then turn it off […]

21 sierpnia 2018

3 minuty

Populate database in Spring

Once upon a time there was BootStrap class. The class was a very friendly class, therefore it befriended many more classes. With more classes inside, BootStrap grew bigger and bigger, expanding itself at the rate of the entire universe. This […]

14 maja 2018

3 minuty

How GitLab helps us move fast at itSilesia

Continuous Integration and Continuous Delivery have taken the world by storm. The nature of our business forces development teams to move quickly and be as efficient as possible, both in regards to standard software development, but also it’s delivery and […]

2 marca 2018

11 minut

Junior Unity Developer poszukiwany

Oferujemy: 1. pracę nad ciekawymi projektami 2. wsparcie doświadczonych Developerów 3. elastyczny grafik 4. dostęp do nowoczesnego sprzętu multimedialnego Wymagania: 1. podstawowa znajomość środowiska Unity 3D 2. ukończone cztery semestry na Politechnice Śląskiej (lub równorzędnej z innej części kraju) […]

15 lutego 2018

1 minuta

Star Wars opening crawl based on CSS animations and transformations

10 years ago nobody expected how frontend is going to evolve in the future. Developers from around the world were using CSS for basic styling because then only that was possible with CSS. Complex things, like animations or transformations, were made thanks to plain […]

9 października 2017

7 minut

School of New Media

Już w najbliższą sobotę, czyli 6 lutego, Katowice staną się stolicą polskiego marketingu internetowego! Równo o 10:00 rusza inauguracja szkoły „School of New Media”, a wraz z nią stanowisko naszej firmy. Zapraszamy do Międzynarodowego Centrum Konferencyjnego, bo itSilesia znajdzie się […]

4 lutego 2016

1 minuta

Kursor Na Marketing

10 lutego do katowickiego Centrum Biznesowego OPOLSKA 22 zawita konferencja „Kursor Na Marketing” o marketingu internetowym. Sukces pierwszej edycji dowiódł zapotrzebowania na wiedzę o skutecznym podboju internetu, a profesjonalny charakter wydarzenia sprawił, że na kolejnej edycji nie może nas zabraknąć […]

4 lutego 2016

1 minuta

SpreadIT 2015

Za nami III edycja popularnej konferencji SpreadIT. Przypominamy, że w tym roku itSilesia została po raz pierwszy brązowym sponsorem tejże konferencji. Nasze stoisko czynne przez cały czas trwania wydarzenia, przyciągało mnóstwo osób, które pytały nas o najnowsze technologie z dziedziny […]

27 listopada 2015

1 minuta

itSilesia brązowym sponsorem na konferencji SpreadIT!

Firma itSilesia została brązowym sponsorem na zbliżającej się wielkimi krokami popularnej konferencji SpreadIT!!! Zapraszamy Was gorąco do odwiedzenia 21 listopada Politechniki Śląskiej w Gliwicach. Będziecie mogli wysłuchać ciekawych wystąpień znanych i popularnych prelegentów. W międzyczasie jeszcze gorącej zapraszamy do […]

12 listopada 2015

1 minuta

itSilesia na Industriadzie

W sobotę 13 czerwca nasza firma wzięła udział największym festiwalu technicznym na Śląsku – Industriada Święto Szlaku Zabytków Techniki. Nasze stanowisko znajdowało się pod radiostacją Gliwicką – najwyższej drewnianej konstrukcji na świecie. Zaprezentowaliśmy zbudowany przez naszego pracownika prototypowy robot-samochodzik sterowany […]

15 czerwca 2015

1 minuta

Nasz projekt na targach ISSA

Nasz najnowszy produkt – zestaw aplikacji opracowanych na zamówienie firmy PPUH VOIGT Sp. z.o.o. mających za zadanie wesprzeć dział sprzedaży na targach ISSA INTERCLEAN 2015. ISSA INTERCLEAN to międzynarodowe targi, które odbyły się 22-24 kwietnia 2015 roku w Warszawie w […]

24 kwietnia 2015

1 minuta

Kalendarz Kopex wygrywa na festiwalu ZoomArt

Z wielką radością informujemy, że kalendarz Kopex wraz z towarzyszącą mu aplikacją rozszerzonej rzeczywistości, którą stworzyła nasza firma, zwyciężył na Międzynarodowym Festiwalu i Konkursie Kalendarzy Zoom Art, który odbył się 14 marca 2015 roku w Katowicach. Kalendarz okazał się bezkonkurencyjny w kategorii F (kalendarz […]

23 marca 2015

1 minuta

Wirtualne lustro dla muzeum w Chorzowie

Nasza wirtualna przymierzalnia została niedawno udostępniona do użytku dla odwiedzających Muzeum „Górnośląski Park Etnograficzny w Chorzowie”. Urządzenie pozwala zwiedzającym przyodziać stroje charakterystyczne dla danego regionu Śląska, a także spróbować swoich sił w grach tematycznych. Zdjęcia w ubraniach ludowych zrobione za […]

20 marca 2015

1 minuta

[SNEAK PEEK] Wizualizacja obwodnicy Nysy

Kolejny, aktualnie powstający, ciekawy projekt, który chcielibyśmy Wam przedstawić to wizualizacja obecnie budowanej obwodnicy miejscowości Nysa.

17 lutego 2015

1 minuta

[SNEAK PEEK] Wirtualna przymierzalnia

Tym wpisem inaugurujemy nowy cykl wpisów, w których będziemy przedstawiać ciekawe projekty, które są tworzone u nas w firmie. Część programistów i artystów działu 3D pracuje aktualnie nad wirtualną przymierzalnią dla Górnośląskiego Parku Etnograficznego w Chorzowie. Dzięki naszym wysiłkom zwiedzający będą […]

2 lutego 2015

1 minuta

Praktyki Web

Dobrze wiadomo, że nie ma lepszej metody nauki niż zdobycie wiedzy na praktykach. Nasza firma ma wieloletnie doświadczenie w realizacji projektów webowych dla międzynarodowych klientów, a teraz zaprasza właśnie CIEBIE na praktyki!

22 stycznia 2015

1 minuta

Praktyki Unity3D

Wszystkich studentów informatyki zainteresowanych grafiką 3D, aplikacjami interaktywnymi i nowymi technologiami oraz chcących zapoznać się z środowiskiem Unity3D zapraszamy na praktyki studenckie w naszej firmie.

22 stycznia 2015

1 minuta

Życzenia świąteczne

Z okazji zbliżających się Świąt Bożego Narodzenia chcielibyśmy złożyć Wam życzenia:spokojnych, śnieżnych, niezwykle rodzinnych i ciepłych najbliższych dni oraz garści dobrych pomysłów i nowych technologii w Nowym Roku. Wesołych Świąt […]

22 grudnia 2014

1 minuta

Nowe technologie w edukacji

Jutro tj. środa 10.12.2014 w godz. 9:30-16:30 będziemy prezentować zalety nowych technologii w edukacji podczas konferencji „Edu IT. Nowe technologie w edukacji” w Centrum Edukacji i Biznesu „Nowe Gliwice” przy ul. Bojkowskiej 37 w GliwicachW programie konferencji m.in. prezentacja treści […]

9 grudnia 2014

1 minuta

Warsztaty Grails

W środę 3 grudnia o 18:00 w sali 623 AEiI będziemy prowadzić warsztaty w ramach spotkań Studenckiego Koła Naukowego Inżynierii Programowania i Inżynierii Językowej. Prowadzić je będzie Łukasz Tenerowicz – nasz software developer. Podczas zajęć powiemy sobie o co […]

1 grudnia 2014

1 minuta

Rarytasy dla aktywnych

Snowcookies rzucają wyzwanie pączkom o tytuł najpopularniejszych polskich ciastek i zdecydowanie nie stoją na straconej pozycji. Zdobędą serca zimowych sportowców, pozwalając na monitorowanie własnego zdrowia oraz osiągnięć. No i nie tuczą. Więcej informacji: http://antyweb.pl/snowcookie-lakomym-kaskiem-dla-fanow-sportow-zimowych-polacy-znow-udowadniaja-swoja-innowacyjnosc/ http://tech.wp.pl/kat,1009783,title,Polacy-w-swiatowym-finale-konkursu-Make-it-Wearable,wid,16954563,wiadomosc.html?ticaid=113a08&_ticrsn=3 […]

15 października 2014

1 minuta

Miasteczko multimedialne MediaTent

Zapraszamy wszystkich miłośników nowych technologii do odwiedzenia naszego stanowiska w plenerowym miasteczku multimedialnym MediaTent. Impreza odbędzie się w najbliższy piątek tj. 19 września na Placu Krakowskim w Gliwicach, w godzinach 10.00 – 20.00. Organizatorami wydarzenia są Miasto Gliwice oraz Śląska Sieć Metropolitalna […]

17 września 2014

1 minuta

Odświeżony wizerunek

Jak mawia klasyk: „siadamy głęboko w fotelach, zapinamy pasy i startujemy”. Nie mamy tylko wstęgi do przecięcia, dlatego kolejny rozdział w historii firmy upamiętniamy inauguracyjnym wpisem. itSilesia przeszła metamorfozę i powraca z nowym wizerunkiem. Przeprowadziliśmy gruntowną zmianę: rebranding marki […]

25 sierpnia 2014

1 minuta